Test ANOVA in analisi statistica

Tra le analisi parametriche più usate in Statistica troviamo il test ANOVA, il cui acronimo sta per Analysis of Variance (analisi della varianza).

Si tratta di una variante del T-test (detto anche test T di Student) che a differenza di questo può essere impiegata per confrontare i dati provenienti da tre o più gruppi. Il T-test invece si limita ad analizzare i set di dati provenienti da soli due gruppi, ma basato sempre sulla varianza dei valori medi.

Dato che trova largo uso in particolare nella ricerca scientifica imparare a conoscerne l’impostazione si rivela utile per futuri medici, biologi o chimici. Per esempio per i trial clinici dove si valutano diversi dosaggi di un farmaco sperimentale, o l’impiego di medicinali diversi a confronto con un gruppo placebo. In questo modo si può capire se risultano efficaci o meno.

Come funziona il test ANOVA

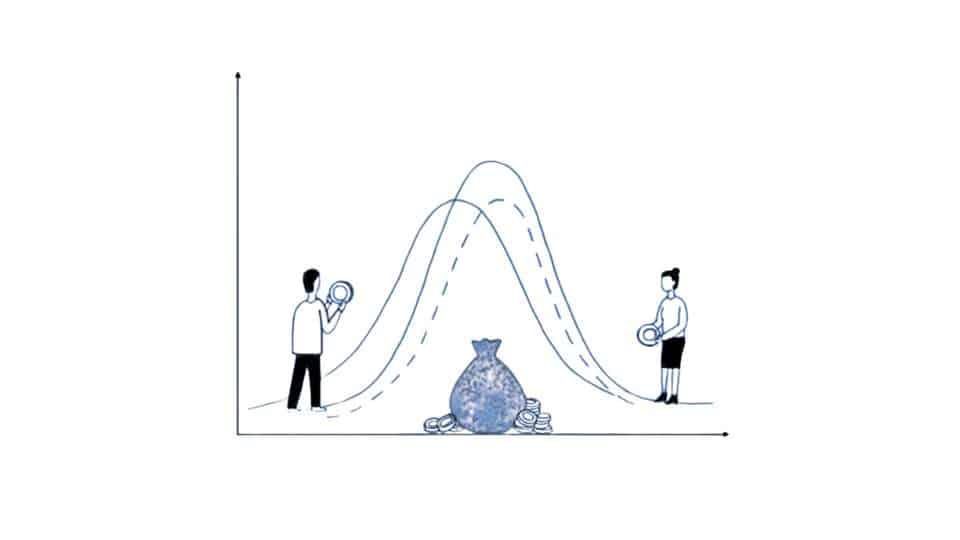

Come per il T-test si tratta di un sistema che consente di mettere a confronto le medie dei valori misurati all’interno di due gruppi per la stessa variabile. Anche se a prima vista calcolando la media fra più set di dati emergono valori diversi grazie a questo tipo di test si può determinare se questa differenza sia dovuta al caso o meno. Nella ricerca medica questo può determinare o meno che un farmaco passi i test preliminari.

Perché i risultati dell’analisi risultino attendibili ci sono delle assunzioni da verificare prima di effettuarlo. Prima di tutto le osservazioni devono essere indipendenti fra di loro, dopodiché la variabile numerica che si sta misurando deve avere una distribuzione normale. Questo requisito è particolarmente importante se il test ANOVA si applica a campionamenti di dimensioni ridotte.

Serve anche l’omogeneità delle varianza, che quindi fra i gruppi da esaminare devono risultare più o meno sovrapponibili. Una volta verificate queste condizioni tuttavia non è finita la fatica perché bisogna stabilire quale versione dell’Analisi della Varianza risulti più adatta alla ricerca che si sta facendo. Vedremo di seguito le varie tipologie e quando valgono.

In tutti i casi occorre però calcolare le medie, sommando la totalità delle misure effettuate e dividendo il risultato per il numero dei dati ricavati. La cosa migliore sarebbe avere dei set di dati identici per numerosità di misure per evitare questo comprometta i risultati finali. La presenza di valori outlier è solo un esempio.

La varie tipologie di analisi della varianza

Ora che abbiamo descritto per cenni generali il test ANOVA vediamo di capire quali forme può assumere:

- One-way (a una via).

Si tratta del caso in cui si ha una sola variabile dipendente e una variabile indipendente qualitativa. Per fare un esempio possiamo immaginare un’analisi dove si hanno tre gruppi di pazienti dove uno è quello di controllo e gli altri due prendono due farmaci diversi. L’obiettivo è vedere se i medicinali favoriscano la diuresi o meno.

- Analisi fattoriale /a due vie/ two-way.

In questo tipo di test la classificazione dei dati raccolti si basa su due parametri anziché uno solo. Vale a dire che abbiamo due variabili indipendenti. Si tratta di una tipologia di analisi più complessa, di cui esempio pratico può essere testare diversi farmaci su condizioni patologiche diverse.

- MANOVA.

Si tratta di una versione del test ANOVA definita anche Analisi Multivariata della Varianza, dove ci sono sia diverse variabili dipendenti che indipendenti. Per questa tipologia di analisi è quanto mai fondamentale che varianze e covarianze siano uguali tra i gruppi in modo da consentire interpretazioni affidabili.

- Analisi della varianza a misure ripetute.

Si usa quando le osservazioni non sono fra loro indipendenti, condizioni necessarie per le tipologie descritte prima. Un esempio è quando si prendono delle misure di peso dalle stesse persone prima e dopo un trattamento.

Interpretare i risultati del test ANOVA

La prima afferma che tutti i gruppi coinvolti nel test hanno la stessa media, ovvero non siano presenti differenze significative anche se dai dati sembra di notarle. L’ipotesi nulla indica anche che tale variabilità può essere dovuta solo al caso, e non per esempio all’effetto prodotto da un farmaco o un trattamento.

Dall’analisi della varianza si ricava un valore F, ovvero il rapporto tra la varianza entro i gruppi e quella che è presente fra di loro. Se si verifica l’ipotesi nulla allora il valore di F sarà pari a 1, mentre se risulta valida l’ipotesi alternativa questo sarà maggiore di 1. Quando è valida l’ipotesi H1tuttavia non è possibile determinare fra molti gruppi quale abbia la media che risulta significativamente diversa.

In questo c’è una differenza netta con il test T, dove essendoci solo due gruppi a confronto non possiamo sbagliare. Svolgendo questo test su programmi statistici come R Project è possibile ricavare oltre a F anche il p-value (per esempio <0,05).

Le analisi post-hoc possibili

Uno di questi è il test HSD di Tukey, detto anche test per le differenze di scala fra due gruppi. Ricava una serie di valori di p ritarati nei confronti a coppie. Tiene conto dell’aumento potenziale dell’errore di tipo I, ovvero quello in cui si rifiuta l’ipotesi nulla quando questa è vera.